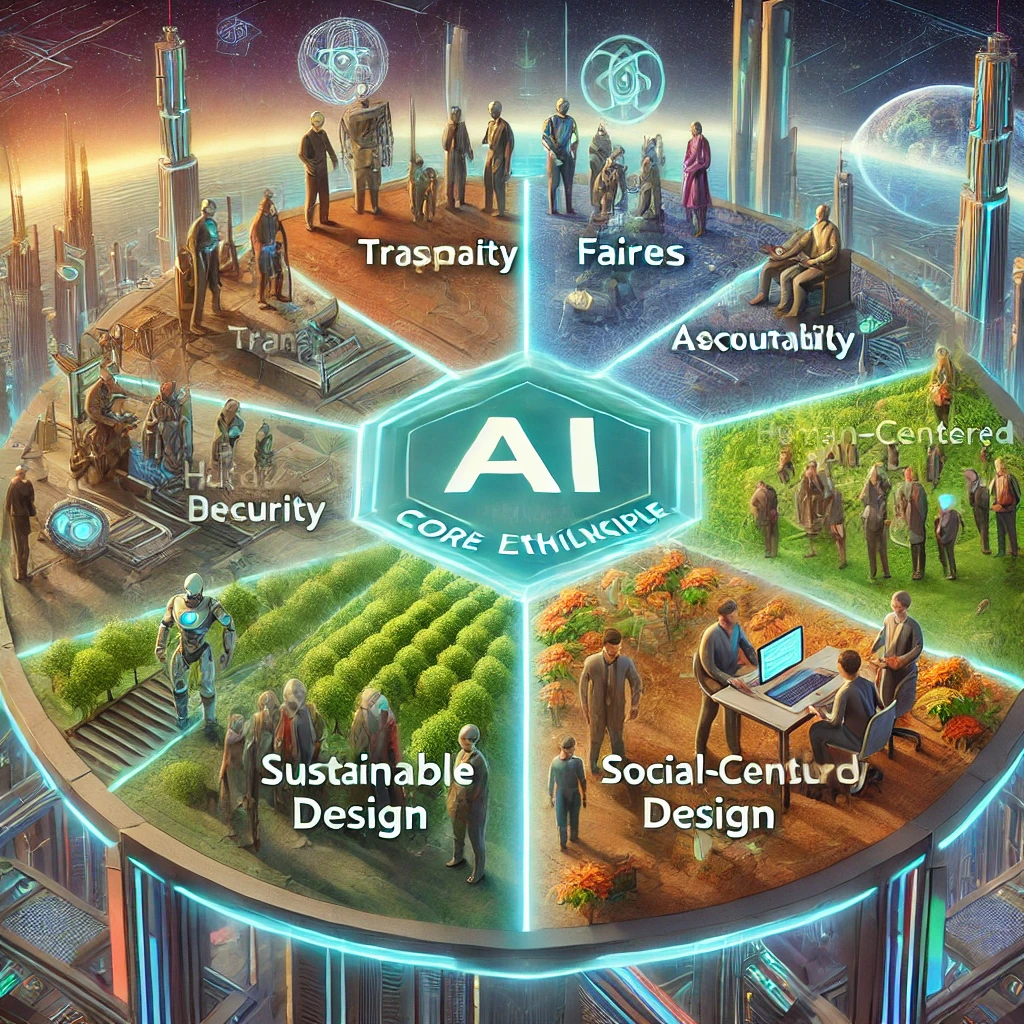

미래를 책임질 AI: 윤리적 사용을 위한 8가지 핵심 원칙

AI의 사용에 있어서 윤리적 부분으로 고려해야 할 사항들은 매우 중요하며, 다양한 측면에서 깊이 있게 고민해야 합니다. AI의 윤리적 사용은 이러한 다양한 측면을 종합적으로 고려해야 하며, 이는 AI 기술이 인간과 사회에 긍정적인 영향을 미치도록 하는 데 중요한 역할을 합니다. 다음은 AI 사용에 있어서 윤리적 부분으로 고려해야 할 주요 사항들입니다.

윤리적 사용을 위한 8가지 핵심 원칙

1. 투명성과 설명 가능성 (Transparency and Explainability)

- 알고리즘의 투명성: AI 시스템이 어떻게 결정을 내리는지에 대한 명확한 설명이 필요합니다. 이는 AI의 작동 방식을 이해하고, 그 결정이 어떻게 도출되는지를 파악할 수 있도록 돕습니다.

- 설명 가능성: AI의 결정이 명확히 설명될 수 있어야 하며, 그 과정이 이해 가능해야 합니다. 이는 특히 의료, 금융, 법률 분야에서 중요한 요소입니다.

2. 공정성과 편향 제거 (Fairness and Bias Mitigation)

- 편향 제거: AI 시스템이 특정 인종, 성별, 연령 등으로 편향되지 않도록 해야 합니다. 데이터 수집 및 알고리즘 설계 단계에서부터 공정성을 유지하기 위한 노력이 필요합니다.

- 형평성 보장: AI의 결정이 공정하고 형평성 있게 이루어져야 하며, 이를 위해 지속적인 모니터링과 평가가 필요합니다.

3. 프라이버시와 데이터 보호 (Privacy and Data Protection)

- 데이터 보호: AI가 사용하는 데이터는 개인의 프라이버시를 침해하지 않도록 보호되어야 합니다. 이는 데이터 수집, 저장, 사용 및 공유 과정에서 철저히 준수되어야 합니다.

- 프라이버시 유지: 개인의 민감한 정보가 AI 시스템을 통해 유출되지 않도록 해야 합니다.

4. 책임성과 책임 소재 (Accountability and Responsibility)

- 책임 소재: AI의 행동에 대한 책임 소재를 명확히 해야 합니다. AI 시스템의 오류나 오작동 시 책임을 질 주체를 명확히 규정해야 합니다.

- 책임성: AI 시스템이 잘못된 결정을 내렸을 때, 이를 수정하고 대응할 수 있는 체계가 마련되어야 합니다.

5. 인간 중심 설계 (Human-Centered Design)

- 인간의 통제권: AI 시스템은 인간의 통제 하에 운영되어야 하며, 인간이 최종 결정을 내릴 수 있는 권한을 가져야 합니다.

- 사용자 경험: AI가 인간과 상호작용할 때, 사용자의 경험을 고려하여 설계되어야 합니다. 이는 AI가 인간에게 친근하고 이해하기 쉬운 방식으로 작동하도록 돕습니다.

6. 안전성과 보안 (Safety and Security)

- 안전성: AI 시스템이 안전하게 작동하도록 설계되어야 하며, 예측하지 못한 행동이나 오작동을 방지할 수 있는 메커니즘이 필요합니다.

- 보안: AI 시스템이 해킹이나 사이버 공격으로부터 안전하게 보호될 수 있도록 강력한 보안 체계가 필요합니다.

7. 사회적 영향 (Social Impact)

- 일자리와 경제: AI의 도입이 노동 시장과 경제에 미치는 영향을 고려해야 합니다. 이는 특히 일자리 감소나 경제적 불평등을 방지하기 위한 대책을 포함합니다.

- 사회적 수용성: AI 기술이 사회에서 어떻게 받아들여지는지, 그리고 그에 대한 인식을 고려해야 합니다. 이는 AI 기술의 사회적 수용성을 높이는 데 중요합니다.